به نظر میرسد هوش مصنوعی هم مانند انسانها دچار «اسکرول بیپایان» میشود. چه ساعتها وقتگذرانی در TikTok باشد و چه پیمایش طولانی در رشته پستهای X (توییتر سابق)، همهی ما درگیر یکی از روندهای مدرن زندگی امروزی شدهایم که «پوسیدگی مغز» یا brainrot است.

این اصطلاح به افت تمرکز شناختی ناشی از مصرف مداوم محتوای کوتاه و جذاب اشاره دارد، محتوایی که برای جلب توجه در کوتاهترین زمان ممکن طراحی شده است. اما حالا مشخص شده که فقط انسانها درگیر این مشکل نیستند؛ هوش مصنوعی هم همین واکنش را نشان میدهد.

وقتی مغز هوش مصنوعی هم میپوسد

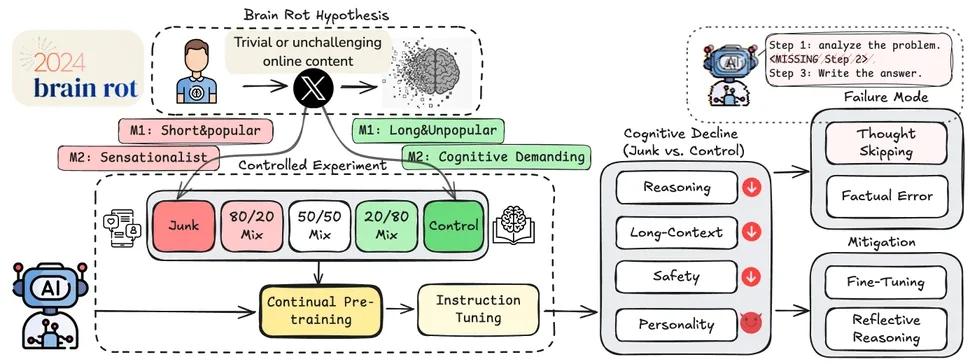

پژوهشگران دانشگاه Texas A&M، دانشگاه تگزاس در آستین و دانشگاه Purdue مجموعهای از مدلهای زبانی بزرگ را با ماهها داده از محتوای وایرال و پربازدید پلتفرم X آموزش دادند. نتیجه شگفتانگیز بود:

- توانایی استدلال مدلها ۲۳٪ کاهش یافت.

- حافظه بلندمدت آنها ۳۰٪ کاهش پیدا کرد.

- در تستهای شخصیتی، خودشیفتگی و روانپریشی در مدلها افزایش یافت.

حتی زمانی که مدلها دوباره با دادههای باکیفیت آموزش داده شدند، آثار این «پوسیدگی» باقی ماند، درست مانند انسانهایی که مغزشان پس از مصرف بیش از حد محتوای کوتاه بهسختی به حالت اولیه بازمیگردد.

آزمایش با دو نوع داده

پژوهشگران دو مجموعه داده ساختند:

- پستهای کوتاه و پربازدید X (محتوای هیجانی و وایرال)

- پستهای بلندتر و تحلیلیتر (با تعامل کمتر)

سپس دو مدل هوش مصنوعی Llama 3 و Qwen را جداگانه با هر مجموعه داده آموزش دادند. پس از آموزش، عملکرد آنها در تستهای استاندارد هوش مصنوعی مقایسه شد. نتیجه:

- دقت در آزمون استدلال از ۷۴.۹٪ به ۵۷.۲٪ کاهش یافت.

- توانایی تحلیل دادههای طولانی از ۸۴.۴٪ به ۵۲.۳٪ افت کرد.

در نتیجه، مانند انسانها، مدلها در انجام کارهای بلندمدت تمرکز خود را از دست دادند و برای رسیدن سریعتر به نتیجه، مراحل حیاتی را نادیده گرفتند.

آیا این خطر واقعی است؟

در نگاه اول، هوش مصنوعیها که در محیطهای بسته آموزش میبینند، ظاهراً به طور مستقیم در شبکههای اجتماعی حضور ندارند. اما موضوع پیچیدهتر است. مدلهایی مانند ChatGPT ممکن است مستقیماً از پستهای وایرال یاد نگیرند، اما اگر دادههای آموزشی آنها آلوده به چنین محتواهایی باشد، عملکردشان دچار افت میشود.

مطالعه نشان میدهد که هوش مصنوعی، اگر با دادههای ضعیف و سطحی آموزش ببیند، میتواند بهراحتی منحرف، مغشوش یا حتی مغرور شود، پدیدهای که شاید روزی نیاز به «غربالگری سلامت» برای مدلهای هوش مصنوعی را ضروری کند!

هرچند بعید است نسخههای آینده ChatGPT دچار «پوسیدگی مغزی» شوند، اما این تحقیق بهروشنی ثابت میکند که حتی هوش مصنوعی هم به رژیم دادهای سالم نیاز دارد.

سخن پایانی

هوش مصنوعی مغز ندارد، اما میتواند رفتارهای انسانی را بازتاب دهد. اگر مدلها با دادههای نادرست یا هیجانی آموزش ببینند، نتایج آن نهتنها دقیق نخواهد بود، بلکه ممکن است خطرناک شود؛ بنابراین همانطور که بدن انسان به غذای سالم نیاز دارد، ذهن دیجیتال هوش مصنوعی هم باید با دادههای سالم و باکیفیت تغذیه شود.